微軟發表新一代自行研發的 AI 晶片 Maia 200,專為大型語言模型(LLM)和生成式 AI 的推論工作負載而設。新晶片強調推論的效能,特定的運用準基測試較 AWS 的 Trainium 高約 3 倍,也超越 Google 的 TPUv7。新晶片已在 Azure 可用,支援旗下的 Copilot 365 和 Azure AI 服務,以及執行 OpenAI 的 GPT-5.2。

Maia 200 加大記憶體

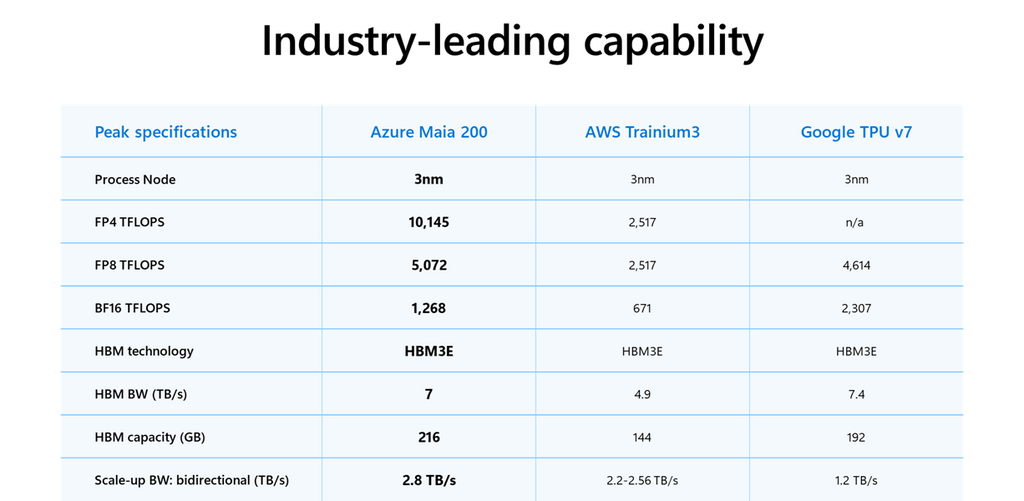

Maia 200 採用台積電 3 納米製程,集成超過 1,400 億個電晶體,配備 216GB HBM3e 記憶體,頻寬 7TB/s,晶片上有 272MB SRAM。較前一代 Maia 100 記憶體的 128GB 增加 70%。晶片繼續採用標準以太網連接,2.8TB/s 雙向頻寬,而不用 NVIDIA 的超高速 NVLink 技術,同樣具備擴展架構,支援最多 6,144 枚 Maia 200 建運算叢集。

Maia 200 的浮點運算性能:

- FP4 (4-bit):提供超過 10 PFLOPS,為 AWS Trainium 3 的三倍。

- FP8 (8-bit):提供超過 5 PFLOPS,超越 Google 的 TPUv7 Ironwood,略高不足一成。

- 功耗:設計功耗(TDP)約 750W,比 NVIDIA Blackwell 系列更節電。

微軟亦同步推出 Maia SDK,支援 PyTorch、Triton 編譯器及模型最佳化工具。

「每元效能」升 30%

微軟在 2023 年推出首款 Maia 晶片,事隔兩年更新 AI 加速器,兩者在定位上有明顯差別。Maia 100 為通用的 AI 加速,而 Maia 200 集中在推論的工作負載,鎖定大規模推論用途,針對低精度運算、記憶體頻寬及效能作出改進。微軟強調,Maia 200 較前一代的每元效能(performance per dollar)提升 30%。

雲端平台的 AI 加速器正在加速競爭,微軟為三大平台最後的入場。Google 早在超過 10 年前推出 TPU,如今至第七代。AWS 旗下自行研發的 AI 加速器有 Inferentia 和 Trainium,將推論和訓練分開,分別在 2018 年和 2020 年首度發表,去年 12 月最新發表 Trainium4。

不過 AI 硬件市場始終由 NVIDIA 主導,即使各雲端平台亦同時有提供 GPU,如 Azure 有 B300、B200、H100 等執行個體可供企業租用。根據市場研究公司的報告,NVIDIA 的 GPU 至今仍是企業客戶在雲端平台的主要選擇,佔超過 70% 市場,亦即餘下的 30% 市場由三間公共雲平台爭逐。