- 廣告 -

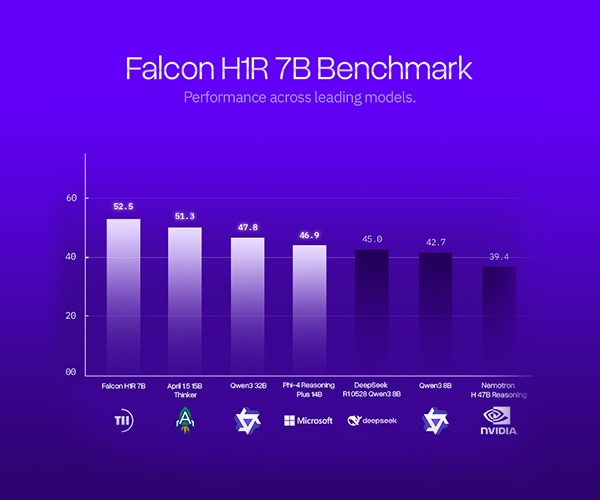

AI 模型推陳出新,不時推出更強勁的模型,今次到中東。阿布達比科技創新研究院(TII)推出小型語言模型 Falcon H1R 7B,僅 70 億參數,推理能力卻更勝 DeepSeek R1-0528 蒸餾版通義千問 3 的 80 億參數,而推理效能更勝兩倍。

TII 的 Falcon H1R 7B 在多項評分均勝過中、小型模型,如數學基準 AIME-24 得分 88.6%,高過 ServiceNow 模型 Apriel 1.5 的 86.2%。在程式碼和代理任務的 LCB v6、SciCode Sub、TB Hard 等評估,Falcon H1R 7B 領先DeepSeek R1-0528 蒸餾版通義千問 3 80B,或更大型的通義千問 3-32B。綜合推理表現,跟微軟的 Phi 4 Reasoning Plus 14B 相近。

Falcon H1R 7B 利用混合 Transformer-Mamba 架構,具備高推理能力,也大幅降低消耗記憶體和能源,推理速度可達每 GPU 每秒約 1,500 字符,較同級 8B 參數的模型效能多近兩倍。

- 廣告 -

TII 將 Falcon H1R 7B 開源,模型權重及完整技術報告已可在 Hugging Face 平台取得,方便研究人員和開發人員深入研究與實際部署。

- 廣告 -