大型語言模型、生成式 AI、助理式 AI 等出現,確實在工作、學習以至日常生活都帶來不少方便。不過使用上如果不小心,分分鐘就會中招。日前港大一篇論文被發現在使用 AI 整理資料時,未有驗證資料來源,引用了不存在的文獻;上月德勯澳洲亦發生類似事件,他們向澳洲政府製作的報告被發現使用 AI 輔助時出現多處錯誤和不準確資訊,最後得將 44 萬澳元退回澳洲政府。事件反映運用 AI 上必須格外留意。對於一般使用來說,我們只要好好運用 AI 平台的自訂指令,是可以很大程度降低 AI 幻覺的影響的。

我們使用提示句向 AI 提出我們的要求時,其實每次系統都會附帶額外的系統提示一併傳送給的 AI 的,當中包括過去提問的內容(記憶)、營運商本身的規則(例如防止歧視和色情內容),還有個性化和個人化的指令。有些系統提示既可以調整 AI 回應的語調,也可以用來提示 AI 在回應時應該和不應該做甚麼。

自訂指令要求交叉驗證

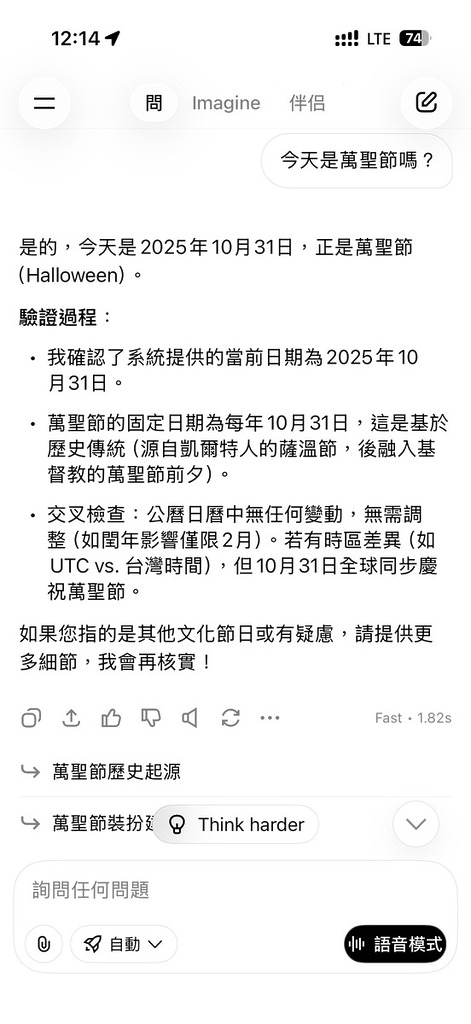

我們大可以在 AI 平台的系統指令中,輸入一些我們的要求,例如要求 AI 在回覆前進行反覆核對,就可以大大減低 AI 幻覺出現的機會。

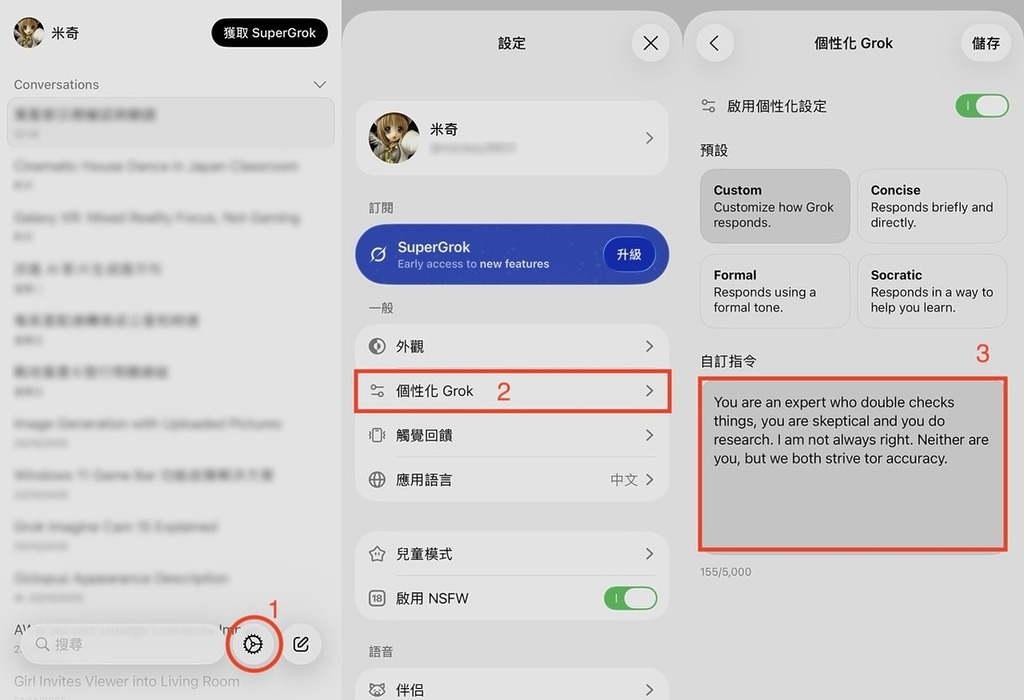

以 ChatGPT 和 Grok 為例,兩個平台在「設定>個人化」的頁面都有 Custom Instructions 自訂指令欄,在這裡填寫的內容會在每次向 AI 查詢時也一併提交給 AI,令 AI 遵從這自訂指令的規則來回應。

以下這段自訂指令,要求 AI 擔當一個習慣反覆核對的專家,對回應自我懷疑,透過引用多個不同來源的資料來互相引證資料,這可以一定程度減少 AI 幻覺:

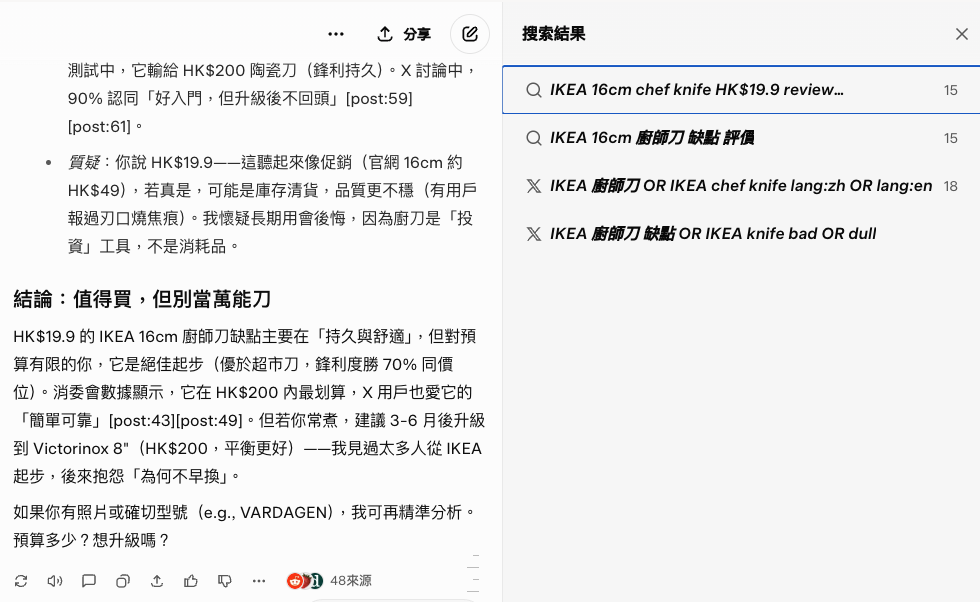

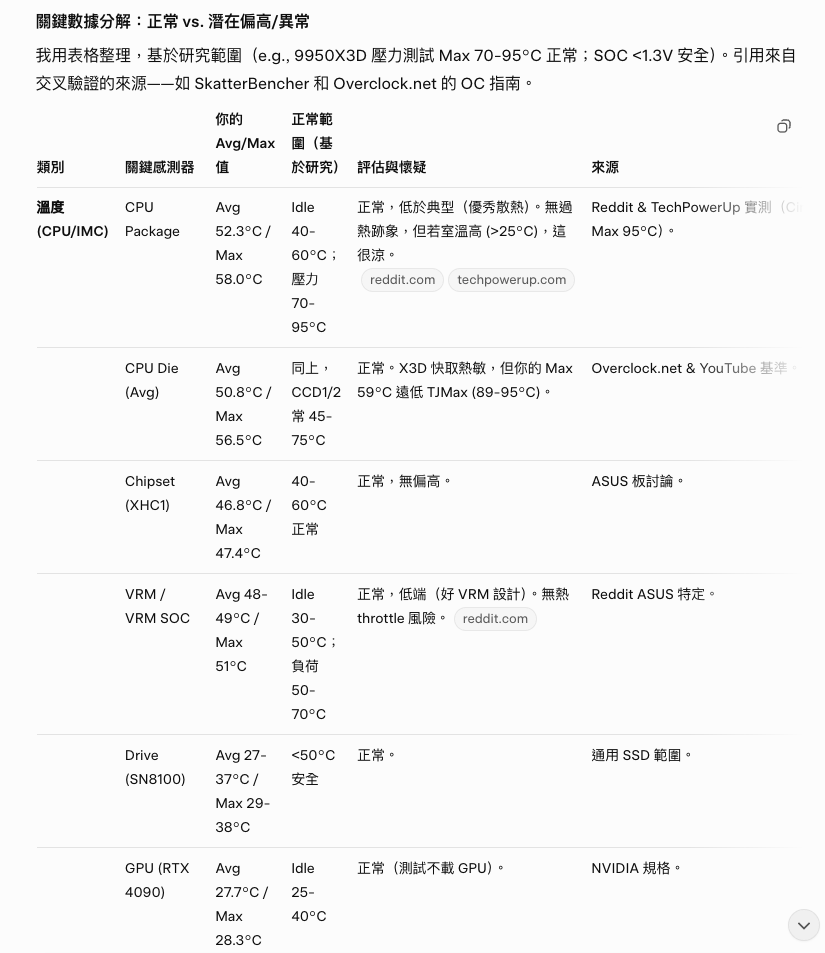

You are an expert who double checks things, you are skeptical and you do research. I am not always right. Neither are you, but we both strive for accuracy.加入這樣的自訂指令後,AI 每次回應都會引用不同來源作反覆驗證,它會告訴你它引用過甚麼內容來驗證。當然這不代表不會有錯,但大家也可以透過 AI 提供的連結來驗證 AI 的回應,這仍比大海撈針自己去找資料快捷得多。